I. 서 론

II. 연구방법

2.1 연구대상

2.2 실험에 사용된 음악

2.3 연구 도구

2.4 자료분석

III. 결과 및 논의

3.1 연구참여자들의 음악인지유형

3.2 안정적/자극적 음악에서의 정서 인식

3.3 정서 인식에 기여한 음악 요소

3.4 음악인지유형별 정서 인식에 기여한 음악 요소

IV. 결 론

I. 서 론

음악은 소리의 복합체로 구성되었으며, 시간적 구조 내에서 다양한 방식으로 전개된다. 소리의 시간적 배열 형태 및 길이에 따라 리듬이 정해지며, 공간적 특성에 따라 조성이 정해지는데, 특히 이 두 가지는 감상자로 하여금 기쁨, 슬픔, 두려움 등 특정 정서를 경험하게 하는 데에 핵심적인 역할을 한다.[1,2,3,4,5]음악에서의 정서지각 및 인식은 사람마다 개별적으로 이뤄지므로, 이에 대한 다양한 접근 시 감상자의 인지행동적, 심리적 특성이 함께 고려되어야 한다.

Baron-Cohen은 개인의 사고방식이나 정보처리방식에서 나타나는 차이를 설명하기 위해 공감-체계화 이론(Empathizing-Systemizing theory, E-S theory)[6]을 제안하였다. E-S 이론은 개인의 인지행동 특성 차이를 ‘공감하기와 체계화하기’라는 두 가지 차원으로 설명하고 있다. 구체적으로 살펴보면 먼저 ‘공감하기’는 타인의 표정, 음성, 몸짓, 행동 등에서 추론 가능한 생각이나 정서에 관심을 갖고, 이를 바탕으로 적절히 반응하고자 하는 욕구와 관련된다. 반면 ‘체계화하기’는 일련의 행동 및 결과에 대해 일종의 체계, 즉 규칙을 만들고 분석함으로써 타인을 이해하고자 하는 욕구와 관련된다.[7]

E-S 이론에 의하면, 개인마다 생물학적 요인 및 사회문화적 환경에 따라 ‘공감하기’가 더 발달했거나 ‘체계화하기’가 더 발달된 행동 특성을 보인다. 태내 환경에서부터 결정되는 성별에 따른 차이를 예로 들면, 여성은 ‘공감하기’ 지수가 ‘체계화하기’ 지수에 비해 더 높은 반면,[8,9,10] 남성은 ‘체계화하기’ 지수가 더 높은 경향을 보인다는 것이다.[11]

Kreutz et al.[12]은 이러한 E-S 이론을 음악 감상에 적용하여 Music Empathizing-Music Systemizing Inventory (ME-MS Inventory)를 제안하였다. 청각신경을 통해 뇌로 전달된 음악은 다양한 감정 및 인지 관련 프로세스를 야기함으로써 궁극적으로는 정서경험을 이끈다.[13] 이는 개인의 인지행동 특성에 따라 뇌에서 음악정보를 처리하는 과정이 달라질 수 있음을 의미한다.[14] 즉, 어떤 이는 음악의 구조적 특징에 기초하여 정서적 반응을 보이는 반면, 또 다른 이는 음악이 전달하는 감정 그대로에 기초하여 강한 정서 경험을 하는 것이다.[15]

음악에서 경험되는 정서는 크게 두 가지로 분류된다. 지각/인식된 정서는 음악 자체에 내재되어 있는 정서로, 음악이 전달 또는 표현하고자 하는 정서를 감상자가 객관적으로 지각한 내용을 말한다. 반면 유도된 정서는 음악에 의해 유발된 감상자의 감정상태로, 주관적인 측면이 더 강조된 내용을 의미한다.[16] 두 가지 정서를 비교한 선행연구에 의하면 음악 경험, 성격 등의 개인 특성은 지각/인식된 정서보다 유도된 정서에 더 큰 영향을 미치는 것으로 나타났다.[17] 단, 해당 연구에서는 감상자의 음악인지유형은 고려되지 않았다.

지금까지 진행된 음악 정서반응 관련 연구들은 음악으로 야기된 심리적 반응에 대해 다양하고 유용한 정보들을 제시하고 있으나, 정작 그 반응에 기여한 음악 요소가 무엇인지, 그리고 감상자의 음악 인지 유형에 따라 정서반응 및 기여한 음악요소가 달라지는지에 대해서는 아직까지 연구된 바 없다. 이에 본 연구에서는 감상자의 음악에 대한 정서반응과 해당 반응에 기여한 음악 요소들을 감상자의 음악 공감-체계화 유형에 따라 확인해보고자 하였다. 단, 음악인지유형과 관련된 첫 번쨰 시도인 만큼, 본 연구에서는 우선 음악에서 인식된 정서에 대해서만 다루었다. 이를 위해 설정된 연구문제는 다음과 같다.

1. 안정적 음악과 자극적 음악에서 인식한 정서는 음악인지유형에 따라 차이가 있는가?

2. 안정적 음악과 자극적 음악에서 정서인식에 기여한 음악 요소는 음악인지유형에 따라 차이가 있는가?

II. 연구방법

2.1 연구대상

본 연구는 음악요소별 분석이 가능한 사람들을 대상으로 수행되어야 한다. 이에 국내 모 여대 음악 관련 전공 대학원생 중에서 참여자를 모집하였다. 자료수집은 총 2회에 걸쳐 이뤄졌으며, 1차 수집은 2018년 12월에, 2차 수집은 2019년 5월에 진행되었다. 참여자는 총 91명이었으나, 질문지 중 누락한 항목이 있는 5명을 제외하고 최종적으로 86명의 자료를 분석에 사용하였다(모두 여성, 평균 연령 = 28.3세). 연구자는 자료 수집에 있어서 (재)국가생명윤리정책원 주최 “[온라인교육] 인간대상연구자를 위한 생명윤리교육” 과정을 이수하여 규정과 지침을 준수하였다

2.2 실험에 사용된 음악

참여자들에게는 연구자들의 합의를 통해 선정된 두 가지의 음악이 제공되었다. 조성, 템포, 강도, 음색 등을 고려하여 서로 대비되는 2가지의 악곡을 선정하였으며, 안정적 음악으로는 벚꽃 지던 겨울의 ‘오후 두 시’ 일부, 자극적 음악으로는 Britten의 ‘Simple Symphony op.4 3rd. Sentimental Saraband’ 일부를 동일한 길이(2 min 10 s)로 각각 발췌하여 사용하였다. 실험장소는 방음시설이 갖춰진 학교 강의실이었으며, IBomb Party XL750 스피커를 사용하여 두 곡 모두 동일한 음량(60 dB)으로 제공하였다. 최종 선정된 2가지 음악의 세부 특성은 Table 1과 같다.

Table 1.

The attributes of grounding and stimulating music.

2.3 연구 도구

본 연구에서 사용된 도구는 모두 자기보고식으로, 연구자들이 직접 구성한 음악정서경험 기록지와 ME-MS척도이다. 연구에 대해 동의 절차를 거친 사람들은 먼저 기본 정보(연령, 음악훈련정보, 일평균 음악청취시간)를 기입한 다음, 다음과 같이 2단계로 실험에 참여하였다.

1단계는 무작위로 재생되는 두 가지 음악을 들으면서 음악정서경험 기록지에 자신의 음악적 경험에 대해 표기하는 것이다. 음악정서경험 기록지는 크게 두 부분으로 구성되었다. 첫 번째 부분은 음악에서 인식한 정서를 Russell[18]의 정서 차원 모델에 따라 각성(arousal) 및 정서가(valence)로 표기하는 것으로, 각각 –5점에서 +5점까지 선택할 수 있도록 구성되었다. 두 번째 부분은, 해당 정서 경험에 기여한 음악 요소들(리듬/템포, 선율, 화성, 다이나믹, 음색, 음조직)을 표기하는 것으로, 각 요소마다 5점 리커트 척도로 구성되었다.

2단계는 ME-MS척도에 응답하는 것으로, 음악인지유형을 확인하기 위해 제시되었다. ME-MS척도는 4점 리커트 척도로 구성된 총 18문항(ME관련 9문항, MS 관련 9문항)의 질문지로 , Kreutz et al.[12]이 개발한 것을 연구자들이 한국어로 번안하여 사용하였다. 이 척도는 기존의 공감-체계화 이론을 음악인지에 적용한 것으로, ME점수가 높으면 음악의 정서적인 면을, MS점수가 높으면 음악의 기술적인 면을 보다 중요시한다고 해석할 수 있다.

2.4 자료분석

참여자들을 ME(음악공감), B(균형), MS(음악체계화) 그룹으로 분류하기 위해, Linnemann et al.[19]의 연구에서와 동일하게 ME-MS의 차이값을 우선 산출한 후 해당 값의 평균과 표준편차로 각 그룹의 컷오프값(M±SD)을 결정하였다. 이렇게 참여자들을 세 개의 음악인지유형 그룹으로 분류한 뒤, 이들의 음악 경험을 통계적으로 확인하기 위해 기술통계, 대응표본 t검정, 분산분석, 다변량분석 및 Pearson 상관분석을 실시하였다. 모든 분석은 SPSS 22.0으로 수행되었다.

III. 결과 및 논의

3.1 연구참여자들의 음악인지유형

전체 참여자들의 ME평균은 29.83점(SD = 3.35), MS평균은 27.27점(SD = 4.29)으로, ME가 더 높게 나타났다. 두 점수 간 차이를 통계적으로 확인하기 위해 대응표본 t검정을 실시한 결과, t = -4.354, p = 0.000으로 유의수준 0.01을 기준으로 유의한 차이를 보였다. 선행연구를 살펴보면 여성의 경우 ME에서 MS보다 더 높은 점수를 받는 경향이 있는데,[12,20] 본 연구참여자가 모두 여성이었다는 점에서 볼 때 이와 동일한 결과라고 사료된다. ME와 MS의 차이값으로 분류된 ME(음악공감), B(균형), MS(음악체계화) 그룹의 연령, 음악훈련기간 등 일반적 특성은 Table 2와 같다.

Table 2.

ME-MS Group informations.

|

MS Group (n = 12) |

B Group (n = 60) |

ME Group (n = 14) | |

| M (SD) | M (SD) | M (SD) | |

| Age | 26.00 (4.09) | 29.03 (7.11) | 27.14 (4.35) |

| Training year | 2.83 (4.15) | 7.47 (7.91) | 8.36 (6.88) |

| DLT | 1.76 (1.02) | 1.50 (0.85) | 1.50 (1.00) |

| ME | 28.33 (3.37) | 29.82 (3.43) | 31.14 (2.60) |

| MS | 31.58 (3.12) | 27.42 (3.92) | 22.93 (2.30) |

| ME - MS | -3.25 (1.29) | 2.40 (1.99) | 8.21 (2.01) |

ME, MS와 음악훈련기간 및 일평균 음악청취시간의 상관 분석 결과, 음악훈련기간은 MS와는 상관관계가 확인되지 않았고, ME(r = .348, p = .001)에서만 낮은 수준에서의 상관을 보였다(Table 3). 이는 선행연구[20]와는 다소 상이한 결과이다. 해당 연구에서는 음악훈련기간이 긴 참여자 집단에서 ME, MS평균이 모두 더 높게 나왔었는데, 본 연구에서 상관관계를 확인한 결과 음악훈련기간은 ME에서만 상관을 보인 것이다.

Table 3.

Correlation analysis among training year, daily music listening time, ME and MS.

| Training year | DLT | ME | MS | |

| Training year | 1 | |||

| DLT | .073 | 1 | ||

| ME | .348** | .322** | 1 | |

| MS | .077 | .349** | .557** | 1 |

일평균 음악청취시간은 ME(r = .322, p = .003) 및 MS(r = .349, p = .001)에서 모두 낮은 수준의 상관을 보였다. 일평균 음악청취시간은 음악과의 친밀도를 의미하며, 음악에 대한 선호나 몰입과도 관련되는 변인이다. 이 점을 고려할 때 본 연구에서 확인한 결과는, ME 및 MS가 음악에의 몰입과 상관관계가 있다는 Sandstrom과 Ruso[21] 연구와 유사한 맥락에 있다고 볼 수 있다.

한편 ME와 MS는 r = .557, p = .000으로 다소 높은 수준의 정적 상관을 보였다. 이는 호르몬에 의한 선천적인 성 차이를 가설로 하는 일반적인 공감(E)-체계화(S) 인지 유형과는 달리, 음악인지유형에서는 ME와 MS간 상호작용이 있음을 의미한다고 볼 수 있다. 또한 위 결과들을 종합하면, 더 나아가 음악훈련 및 청취를 통해 ME 또는 MS가 편향되게 발달하는 것이 아니라, 균형적 발달이 가능함을 유추할 수 있다.

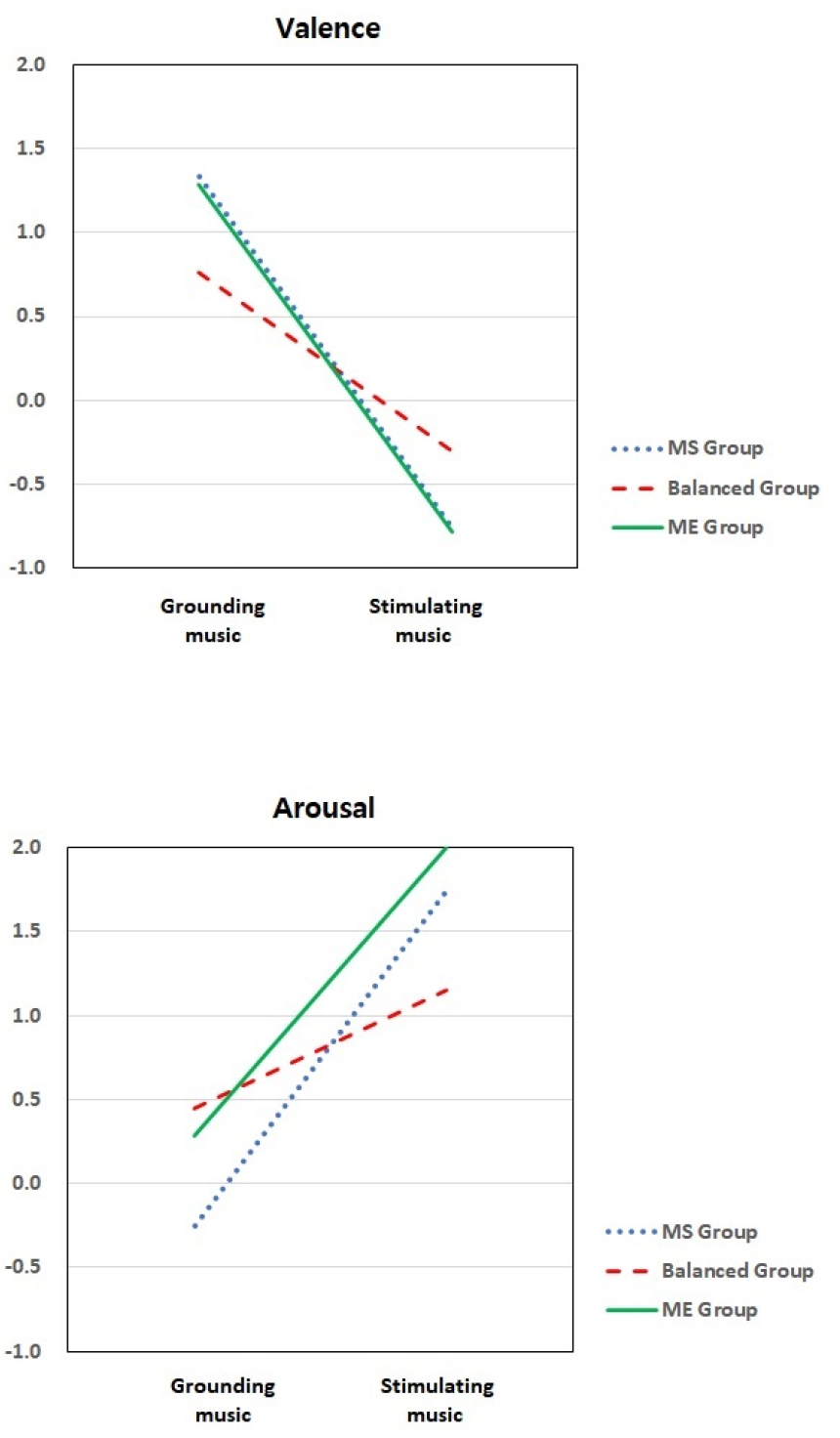

3.2 안정적/자극적 음악에서의 정서 인식

안정적 음악과 자극적 음악에서 인식한 정서를 서로 비교하기 위해 다변량분석을 실시한 결과, 음악특성에 따른 주 효과는 정서가 F(1,166) = 10.253, p = .002 각성 F(1,166) = 10.324, p = .002 모두 통계적으로 유의했으나, 음악인지유형에 따른 주 효과는 정서가 F(2,166) = .004, p = .996, 각성 F(2,166) = .267, p = .766 모두 통계적으로 유의하지 않았다. 또한 음악특성과 음악인지유형의 상호작용도 정서가F(2,166) = .597, p = .552 및 각성 F(2,166) = 1.106, p = .333 모두 유의하지 않았다(Fig. 1). 종합하면 참여자들은 인지유형에 관계 없이, 음악의 구성요소와 전개방식에 따라 공통적인 정서(즉, 안정적 음악에서는 긍정정서와 낮은 각성, 자극적 음악에서는 부적 정서와 높은 각성)를 인식했다고 볼 수 있다.

선행연구[22]에 의하면 선율, 화성, 템포 등의 음악특성은 정서가 및 각성에 영향을 미친다. 구체적으로 협화음과 느린 템포는 긍정정서 및 낮은 각성과 연관되며, 텐션 중심의 화성 진행과 빠른 템포는 부적 정서 및 높은 각성을 유발하는데, 본 연구결과에서도 이와 유사한 결과가 나타난 것이다. 또한 음악을 감상하는 동안 경험되는 정서에 영향을 미치는 음악훈련,[23] 심리상태[24]등의 변인과는 달리, 음악인지유형은 정서인식 내용과는 무관하다는 것을 결과를 통해 확인했다.

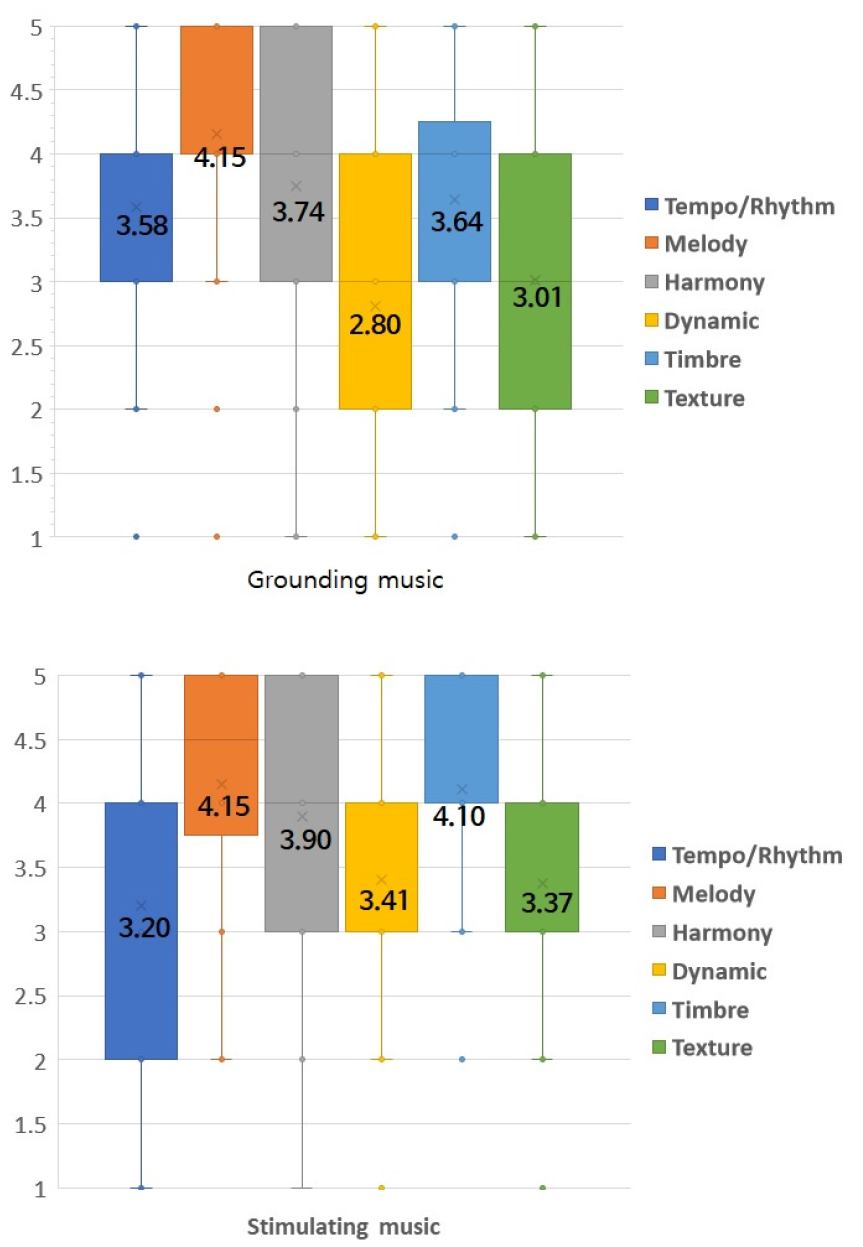

3.3 정서 인식에 기여한 음악 요소

안정적 음악과 자극적 음악에서 정서인식에 기여한 음악 요소를 5점 리커트 척도로 정량화하여 비교한 결과, 안정적 음악과 F(6,595) = 18.837, p = .000 자극적 음악 F(6.595) = 14.137, p = .000 모두에서 통계적으로 유의한 차이를 보였다. 이는 음악요소별로 정서인식에 기여한 수준에 차이가 있음을 시사한다.

사후검정 Duncan 실시 결과, 안정적 음악에서는 ‘선율(M = 4.15, SD = .89)’이 가장 주요하게 정서인식에 기여한 것으로 나타났고, 자극적 음악에서는 ‘선율(M = 4.15, SD = 1.02)’, ‘음색(M = 4.10, SD = .87)’, ‘화성(M = 3.90, SD = .90)’ 세 항목이 정서인식에 주요하게 기여한 것으로 나타났다(Fig. 2).

정리하면 두 가지 음악 모두에서 정서인식에 선율이 가장 크게 기여한 것으로 보고되었는데, 이는 Khalfa et al.[25] 이 언급했듯이 음악을 통한 다양한 정서경험에는 템포/리듬 뿐 아니라 선율의 비중 있는 역할이 특히 요구된다는 연구 결과와 같은 맥락에 있다고 볼 수 있다. 한편 Gabrielsson과 Lindstrom[26]의 연구에서는 단선율 중심의 비교적 단순한 음조직은 행복과 같은 긍정정서와 관련되며, 다성부가 활용된 복합적인 음조직은 슬픔과 같은 부적 정서를 더욱 지지한다고 보고되었으나, 본 연구에서는 두 음악 모두에서 음조직의 기여도가 타 항목에 비해 상대적으로 큰 비중을 차지하진 않았다.

3.4 음악인지유형별 정서 인식에 기여한 음악 요소

안정적 음악과 자극적 음악에서 정서인식에 기여한 음악 요소를 음악인지유형에 따라 살펴본 결과는 Table 4와 같다.

Table 4.

Musical elements contributing to perceived emotion of grouonging/stimulating music according to cognitive styles of music listening (N = 86).

| MS Group (M) | B Group (M) | ME Group (M) | ||||

| GM | SM | GM | SM | GM | SM | |

| Tempo/Rhythm | 3.83 | 2.83 | 3.62 | 3.27 | 3.21 | 3.21 |

| Melody | 4.08 | 4.08 | 4.23 | 4.22 | 3.86 | 3.93 |

| Harmony | 3.58 | 3.67 | 3.87 | 3.97 | 3.36 | 3.79 |

| Dynamic | 2.58 | 3.75 | 2.90 | 3.27 | 2.57 | 3.71 |

| Timbre | 3.42 | 4.42 | 3.73 | 4.07 | 3.43 | 4.00 |

| Texture | 2.75 | 3.67 | 3.07 | 3.23 | 3.00 | 3.71 |

B(균형적)그룹의 경우 안정적 음악과 F(6,413) = 12.681, p = .000 자극적 음악 F(6,413) = 11.158, p = .000 모두에서 ‘선율’이 가장 크게 기여한 것으로 나타났다. 반면 MS(음악체계화)그룹은 안정적 음악에서는 ‘선율’이 F(6,77) = 4.535, p = .001, 자극적 음악에서는 ‘음색‘이 F(6,77) = 4.613, p = .000 가장 크게 기여한 것으로 나타났다. ME(음악공감)그룹에서도 MS그룹과 동일하게 안정적 음악에서는 ‘선율’이 F(6,91) = 2.819, p = .015, 자극적 음악에서는 ‘음색’이 F(6,91) = 1.041, p = .404 가장 크게 기여한 것으로 나타났다. 다만 ME그룹의 경우 자극적 음악에서 정서인식에 대한 ‘음색’의 기여도는 통계적으로는 유의하지 않았다.

특히 음색은 MS그룹과 ME그룹에서 자극적 음악을 감상할 때 가장 큰 영향을 끼치는 것으로 나타났는데, 이는 음색이 감정 인식에 영향을 미친다는 선행연구[27]와 맥락을 같이 하면서, 음악인지유형에 따라 보다 세분화된 결과를 보여주고 있다고 볼 수 있다.

IV. 결 론

본 연구에서는 음악정서 인식에 기여한 음악 요소들을 음악 공감-체계화 유형에 따라 탐색하였다. 연구결과 및 논의를 통해 얻은 결론은 다음과 같다.

참여자들은 음악인지유형과는 무관하게 음악의 구성요소와 전개방식에 따라 공통적인 정서 경험을 했는데, 이는 음악을 통한 보편적 정서 경험이 가능하다는 것, 그리고 음악 구성요소 특성에 따라 특정 정서를 유도하는 것이 가능하다는 것을 지지하는 결과라고 할 수 있다. 또한 음악인지유형(음악 공감/음악 체계화), 음악특성(안정적 음악/자극적 음악) 및 정서경험 영역(정서가/각성)에 따라 해당 정서경험에 주로 기여한 음악요소가 각각 확인되었는데, 이는 다양한 경로의 음악추천시스템[28]이 제안되고 있는 상황에서 어떤 음악요소들을 중심으로 결정할지 참고할 수 있는 하나의 기준으로서 의미가 있다고 하겠다.

본 연구는 음악 공감-체계화 유형에 따른 음악정서 인식을 비교했다는 점, 그리고 해당 인식에 기여한 음악 요소들을 탐색해 본 첫 번째 시도였다는 점에 그 의의가 있다. 본 연구는 음악 관련 전공 여자 대학원생들만을 대상으로 하였으며, 지각/인식된 정서에 대해서만 다루었다는 제한점이 있다. 또한 음악적 특징이 두드러지게 다른 두 곡을 사용했을 뿐, 다양한 정서가 내재된 다수의 곡들을 기준으로 탐색하지 못했다. 향후 연구에서는 다양한 대상군으로 참여자를 확대하며, 인식된 정서 뿐 아니라 유도된 정서까지 포함해서 폭넓게 탐색해 볼 필요가 있다.