I. 서 론

II. 플랫폼 운동의 종류 및 수학적 표현

III. 합성개구소나 영상 생성 알고리즘 및 왜곡에 의한 영상 오차의 정의

IV. 운동 파라미터에 의한 영상 왜곡 분석

V. 결 론

I. 서 론

수중 해저면 영상 취득을 위해 측면주사소나 또는 다중빔음향측심기 등이 널리 사용되고 있으며, 상대적으로 고해상도의 해저면 영상 획득이 가능한 합성개구소나(Synthetic Aperture Sonar, SAS)가 상용화 되어 그 활용이 증대되고 있다.[1,2,3] 또한 해저에 매몰되어 있는 표적을 탐지하기 위하여 수 kHz에서 수십 kHz의 중저주파수 영역을 사용하는 합성개구소나 연구도 활발히 진행되고 있다.[4,5]

합성개구 신호처리 기법은 송수신 센서를 이동하면서 여러 위치에서 취득한 데이터를 동시에 활용하여 물리적인 센서의 구경 크기보다 더 큰 배열 구경 효과를 가져 옴으로써 영상 해상도를 높이는 방법으로서[6,7] 예인체[3] 또는 자율무인잠수정(Autonomous Underwater Vehicle, AUV)[1]에 탑재되어 운용된다. 해외의 경우 수십년 전부터 합성개구소나에 대한 연구가 수행되어 왔으며,[8,9] 고도를 추정하기 위한 간섭계 합성개구소나에 대한 연구도 진행된 바 있다.[10] 국내의 경우 대학과 연구소를 중심으로 수신되는 음향 신호를 이용한 영상 보정[11]과 플랫폼 이동 속도에 대한 영향 분석,[12] 반사파를 제거하기 위한 연구[13] 등 관련 신호처리 연구가 수행된 바 있다. 최근에는 국내 소나개발업체를 중심으로 예인형 합성개구소나 시스템을 개발 중에 있다.[14]

고해상도의 합성개구소나 영상을 취득하기 위해서는 합성개구소나를 탑재하고 있는 플랫폼의 운동을 정확하게 추정하는 것이 필요하다. 일반적으로는 관성측정장치(Inertial Measurement Unit, IMU)나 자세센서(Attitude, Heading Reference System, AHRS) 등의 항법센서를 이용하며 수신 신호를 이용하여 운동 추정치를 보정하는 방법이 사용되기도 한다. 따라서 정확한 운동을 추정하기 위해서는 항법센서의 정확도가 매우 중요하다. 국내에서 자율무인잠수정의 항법을 위해서 사용되는 항법센서로는 FiberPro의 FI200 시리즈와 Honeywell사의 HG 시리즈 등이 있으며, 이들은 0.006°/√h ~ 0.5°/√h의 각도 무작위행보와 0.02 m/s/√h ~ 0.2 m/s/√h의 속도 무작위행보를 갖는다.[15,16] 이중에서 가장 정밀한 센서를 선택하는 것이 제일 좋겠지만 플랫폼의 크기와 운용 시간 등을 고려하여 최적의 센서를 선택할 필요가 있다. 또한 운동의 특성에 따라 영상 생성에 미치는 영향이 다를 것이므로 어떠한 운동 특성을 정확하게 계측해야 하는지, 얼마나 정밀한 항법 센서를 사용해야 하는지 살펴 볼 필요가 있다.

이를 위해 본 논문에서는 선형주파수변조(Linear Frequency Modulation, LFM) 신호를 사용하는 합성개구소나 신호처리에 있어서 외란에 의해 이상적인 등속 직진 운동이 아닌 다른 형태의 운동이 발생하는 경우 운동을 표현하는 변수 값에 따라 합성개구소나 영상의 왜곡의 정도를 정량적으로 분석하고자 한다. 탑재체의 형상 특성에 따라 총 다섯 종류의 운동을 고려하며 합성개구소나 신호처리 알고리듬은 공간 주파수 영역 보간법 방법을 적용하고자 한다. 일반적으로 수중 플랫폼이 6자유도를 갖는 복잡한 운동 특성을 나타내고 있으나 특정 좌표나 각도가 변화하는 간단한 운동 특성이 미치는 영향 분석은 이를 조합한 복잡한 운동 특성의 결과를 해석하는데 유의미한 결과를 도출할 수 있으므로 본 논문에서는 다섯 가지의 기본적인 운동에 대한 수치해석 결과를 기술하고자 한다.

본 논문의 구성으로 먼저 제 2장에서는 플랫폼의 운동을 수식으로 표현하여 상세하게 설명하고자 하며, 제 3장에서는 본 논문에 사용되고 있는 합성개구 신호처리 알고리즘과 정량적 분석을 위한 오차의 정의에 대해 소개한다. 제 4장에서는 변수값을 변화시켜 가면서 운동 특성에 따른 왜곡의 정도와 생성된 영상을 파악하고자 하며, 제 5장에서 결론을 맺는다.

II. 플랫폼 운동의 종류 및 수학적 표현

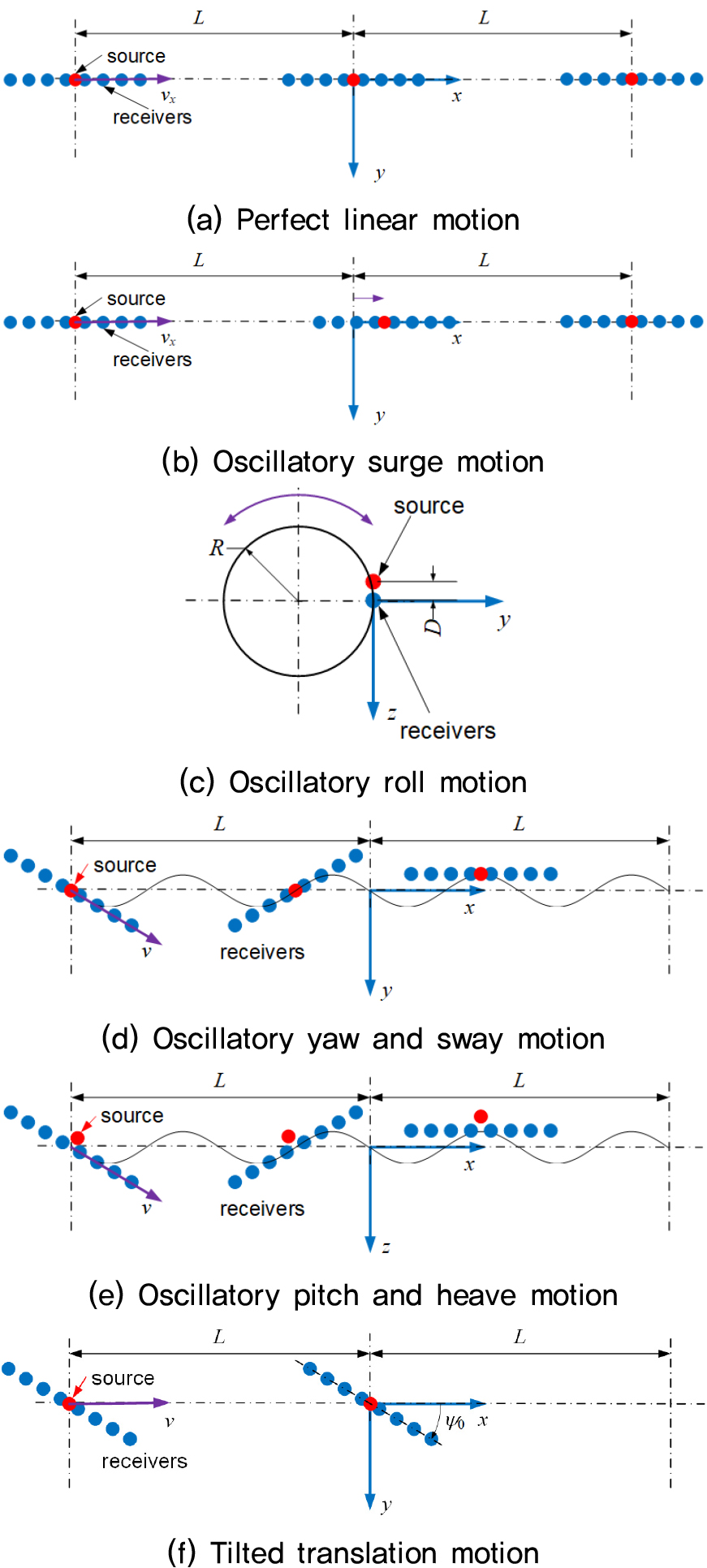

합성개구소나는 신호처리 원리의 특성으로 인하여 직진 운동을 하는 예인체나 자율무인잠수정에 탑재되어 운용되며, 대부분 어뢰와 같은 원통형 형상을 갖는다. 이와 같이 단면의 크기에 비해 전후 방향의 길이가 긴 플랫폼 형상으로 인하여 상하 또는 좌우 방향의 병진 운동보다는 상대적으로 저항이 작은 전후 방향의 수중 운동 특성이 주로 나타난다. 본 연구에서는 이와 같은 운동 특성을 고려하여 Fig. 1에 도시한 여섯 가지의 플랫폼 운동을 고려하고자 한다.

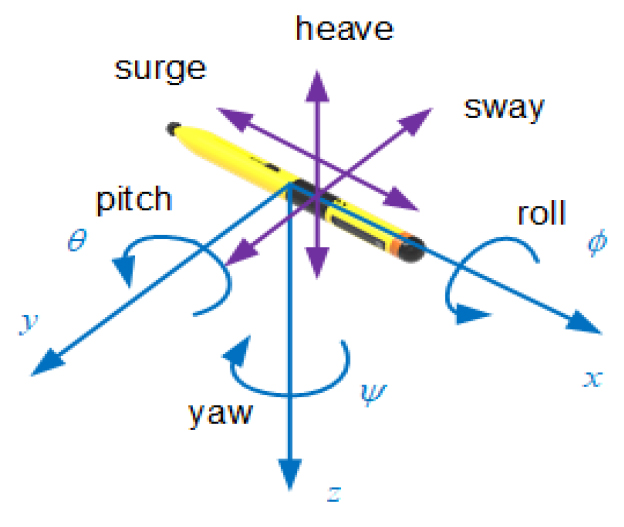

여기서 Fig. 1(f)는 플랫폼이 일정한 각도로 틀어진 상태에서 직진하는 운동으로서 해류가 존재하는 수중 환경에서 나타날 수 있는 경우를 가정하여 포함시켰다. Fig. 2는 본 연구에서 사용된 좌표계를 나타낸다. 수신배열 센서가 이동하는 방향을 축, 음파가 방사되는 수평면 방향을 축, 수심 방향을 축으로 하는 좌표계로서 각 축을 중심으로 회전하는 운동을 나타내는 roll, pitch, yaw는 각각 의 기호를 사용하며, surge, sway, heave는 각 축 방향으로의 병진 운동을 나타낸다. Fig. 1의 각 운동에 대해서 번째 수신배열 센서의 좌표 를 수학적으로 표현하면 다음 식과 같다.

(a) Perfect linear motion

(b) Oscillatory surge motion

(c) Oscillatory roll motion

(d) Oscillatory yaw and sway motion

(e) Oscillatory pitch and heave motion

(f) Tilted translation motion

여기서 는 수신배열 센서의 센서 간격을, 와 는 각각 surge, sway, heave, roll의 요동 크기와 주파수를 의미하며, 은 배열센서 중심을 기준으로 번째 센서까지의 변위를 의미한다. 은 각각 센서의 개수, 방향의 속도, 소나 플랫폼의 반경을 나타내며, 하첨자 0은 초기값을 의미한다.

III. 합성개구소나 영상 생성 알고리즘 및 왜곡에 의한 영상 오차의 정의

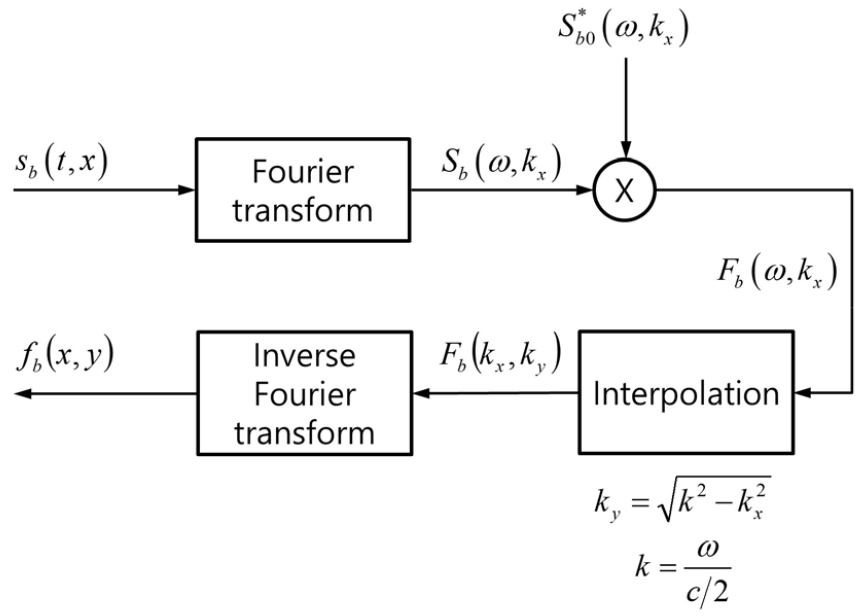

합성개구 신호처리를 이용한 영상 생성 알고리즘에는 공간 주파수 영역 보간법, 거리 적층 알고리듬, 시간 영역 상관 및 배면 알고리듬 등이 있다.[6] 본 논문에서는 이중 상대적으로 처리시간 측면에서 유리한 공간 주파수 영역 보간법을 이용한 알고리듬을 사용하고자 한다. 본 알고리듬의 흐름도는 Fig. 3에 나타난 바와 같다.[6]

여기서 는 수신 신호의 기저대역 값을 의미하며, 는 합성개구소나의 초음파 영상값으로서 복소수 값을 가진다. 파수 로서 왕복 시간을 고려하여 음속 대신에 가 사용됨에 주의가 필요하다.

영상 왜곡의 정량적 분석을 위해서 다음 식과 같이 정규화된 평균 제곱근 오차(Normalized Root Mean Square Error, NRMSE)를 정의한다.

여기서 는 플랫폼 운동에 의해서 생성된 왜곡된 영상값을 나타낸다. 영상 왜곡이 존재하지 않아 인 경우 NRMSE = 0이 되며, =0인 경우 NRMSE = 1의 값을, 인 경우에는 NRMSE = 2의 값을 갖는다.

IV. 운동 파라미터에 의한 영상 왜곡 분석

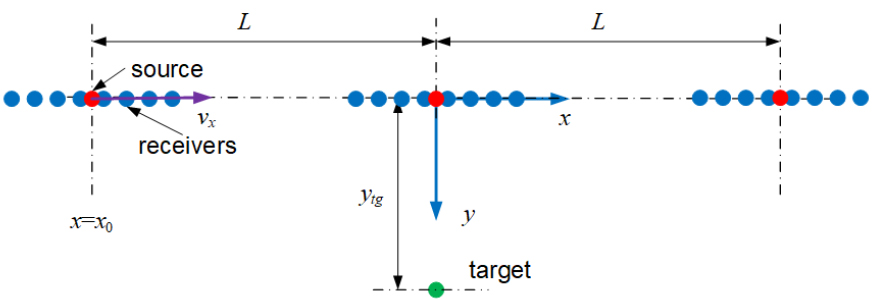

운동 파라미터에 의한 영상 왜곡의 정량적 분석을 위해 수치해석을 수행하였다. 수신 센서에서의 수신 신호를 모의하기 위하여 선박해양플랜트연구소에서 개발한 소나 채널 모델링 프로그램[17]을 이용하였으며 다른 변수에 의한 영향을 배제하기 위하여 무지향성 송수신 센서, 무지향성 점 표적, 반사파가 존재하지 않는 공간, 일정한 음속 분포 등 이상적인 환경을 가정하였다. 송신 신호는 Kaiser-Bessel 창문함수가 적용된 선형주파수변조 신호를 사용하였으며 25 kHz의 중심주파수에 20 kHz의 대역폭 신호를 사용하였다. 배열 센서는 25 kHz에서 반파장 간격으로 구성되어 있는 경우를 가정하였으며 1 m/s의 이동속도와 0.25 s의 신호발생주기를 고려하여 16개의 수신 센서로 구성된 배열을 가정하였다. 영상왜곡 분석 영역은 표적을 중심으로 ±5 m 이내로 한정하였다. 본 논문에서는 점 표적을 사용하므로 표적 위치에서만 값이 존재하여야 하며 그 외는 모두 오차가 발생하는 것으로 간주할 수 있다. 그 밖의 세부적인 변수를 Table 1에 나타내었으며 수치해석 수행 조건 개념도를 Fig. 4에 도시하였다.

Table 1.

Simulation parameters.

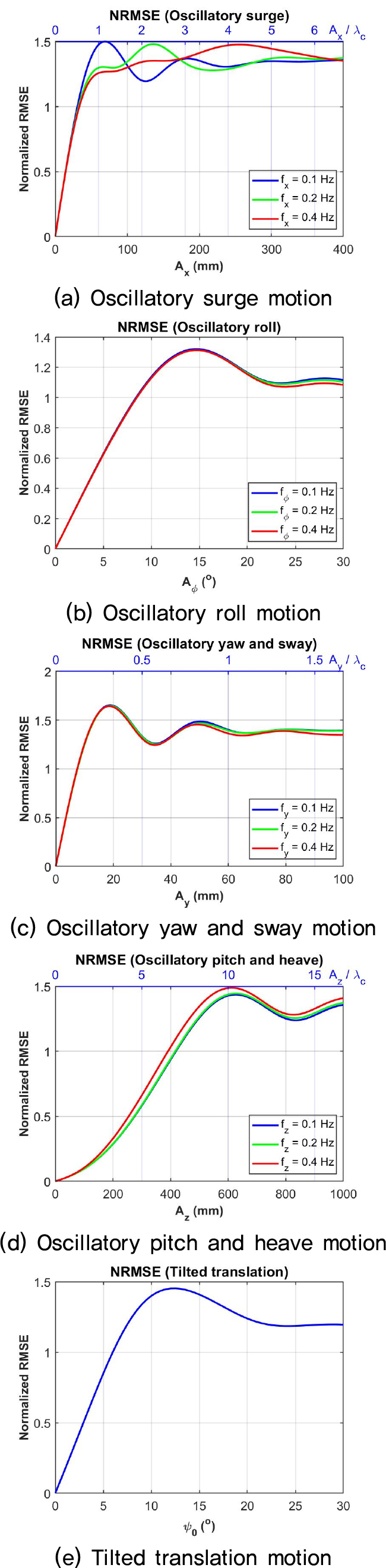

영상 왜곡 분석을 위한 플랫폼 운동의 파라미터의 범위 및 간격은 Table 2에 나타난 바와 같다. 실제 환경에서 발생 가능한 운동의 범위는 한계가 없기 때문에 최대 NRMSE 값이 나타나는 범위를 고려하여 최대 크기를 설정하였다. 요동의 주파수는 0.1 Hz, 0.2 Hz, 0.4 Hz로서 이는 1 m/s로 이동하는 경우 합성개구면의 크기인 10 m를 이동하는 동안에 각각 1, 2, 4번의 요동이 있는 경우에 해당된다. Fig. 5는 오차 분석 결과를 나타낸다. 요동의 크기가 증가할수록 영상 오차도 증가하며 일정 값 이상에서는 더 이상 증가하지 않고 포화되며, pitch와 heave 운동을 제외하고는 요동의 크기가 작은 경우에 선형적으로 증가하는 특성을 보인다.

Table 2.

Platform motion parameters.

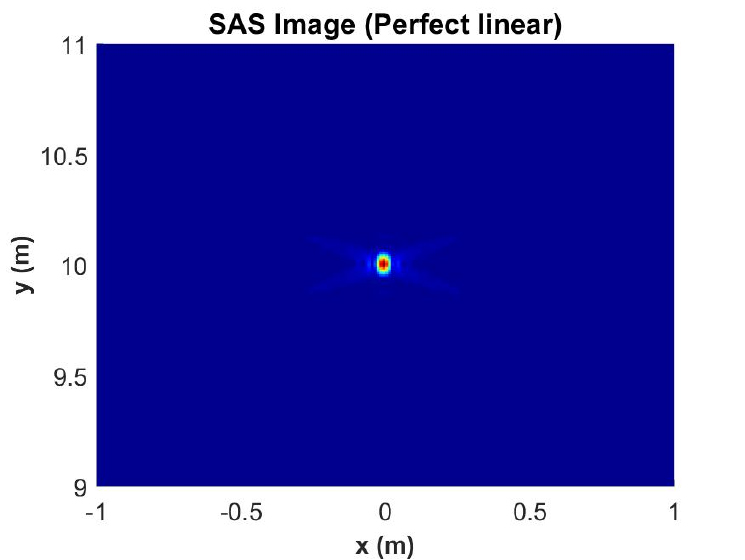

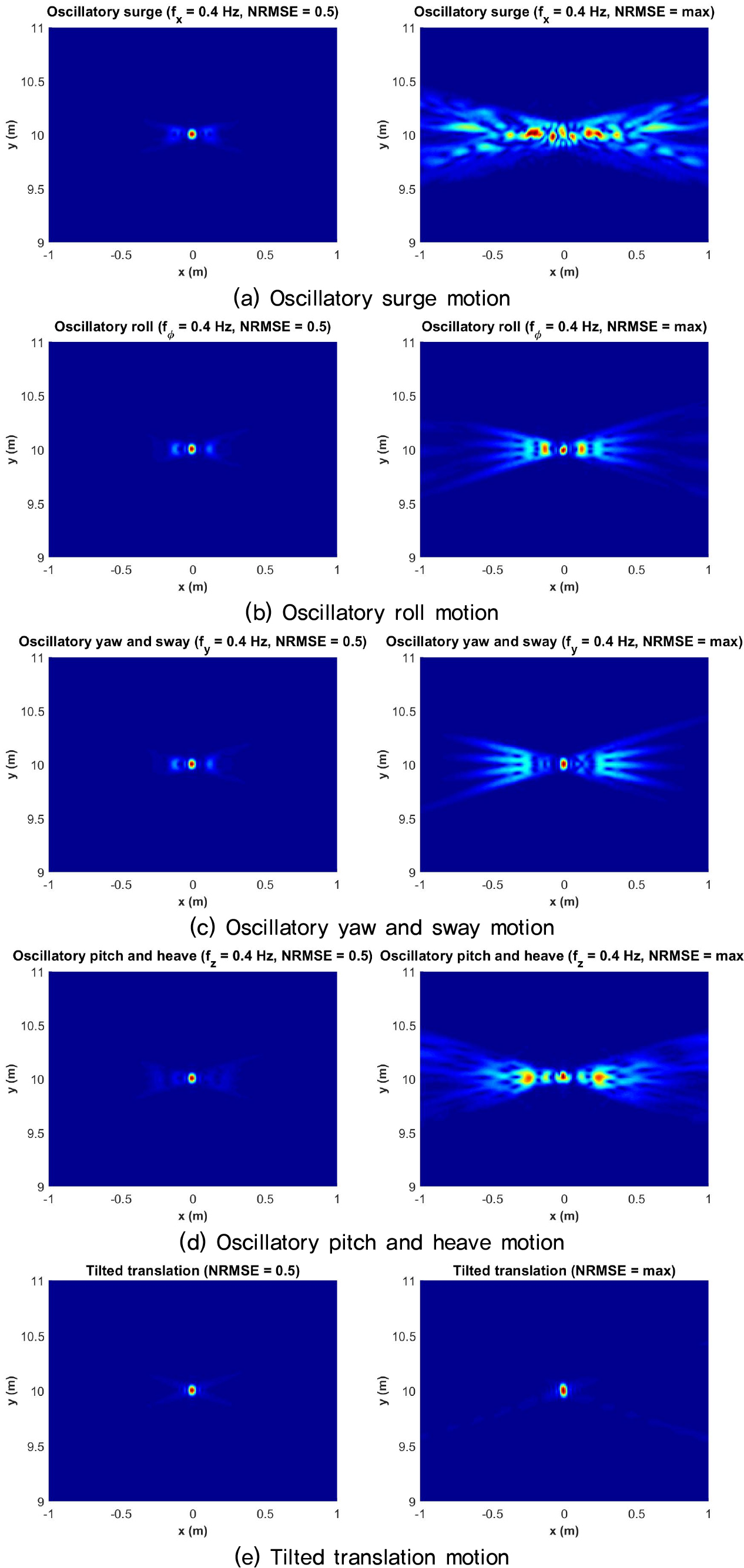

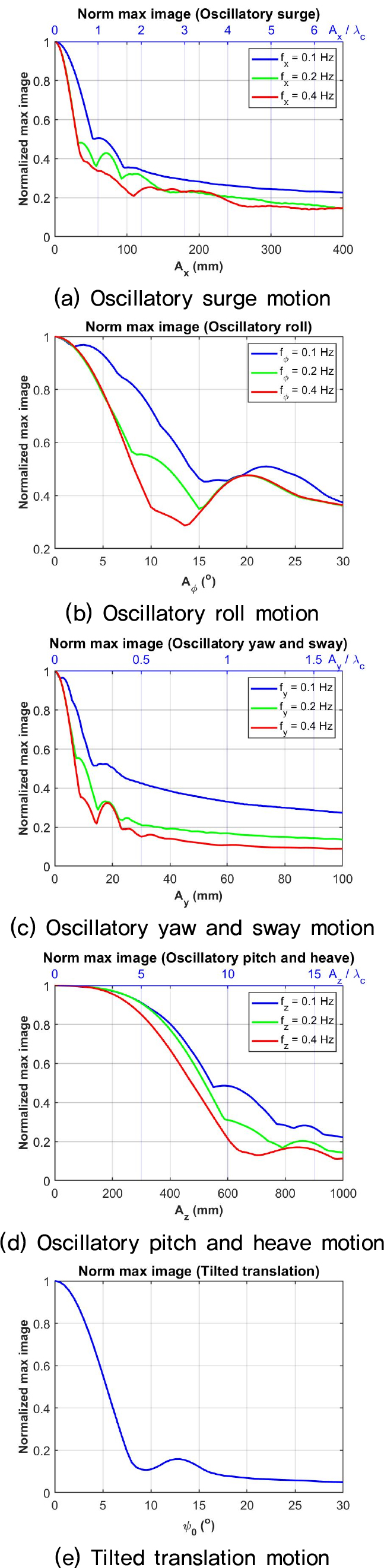

Table 3은 NRMSE 값이 0.1, 0.5와 최대값을 갖는 경우에 대한 요동의 크기를 나타낸다. 약 3.5 mm의 sway 요동 크기에서도 NRMSE = 0.5가 되어 yaw and sway 운동이 영상 생성에 가장 큰 영향을 미치며, 이는 요동 주파수 0.1 Hz의 경우 0.13°의 yaw의 요동 크기에 해당된다. 반대로 pitch 요동의 크기는 약 270 mm인 경우에 NRMSE = 0.5가 되어 pitch and heave 운동이 가장 작은 영향을 미침을 알 수 있다. Fig. 6은 이상적인 선형운동을 하는 경우의 합성개구소나 영상을 나타낸다. 표적이 위치하는 곳에서만 큰 값을 가지며 실제 값과 일치함을 알 수 있다. Fig. 7은 각 요동 운동에 대해서 NRMSE = 0.5와 최대값인 경우에 대한 영상을 보여주고 있다. NRMSE값이 최대인 경우의 영상을 보면 대체로 축 방향으로 분산되거나 여러개의 표적이 존재하는 현상이 나타난다. NRMSE = 0.5인 경우에는 원 영상인 Fig. 6와 큰 차이가 나타나지 않는데 이는 Fig. 8과 같이 표적이 존재하는 위치에서의 영상 값이 감소하기 때문에 나타나는 오차이다. 이는 표적 위치에서의 영상 값이 다른 위치로 분산되는 것을 의미한다. 또한 Fig. 5에서 변위와 각도가 증가함에 따라 오차가 일정 수준에서 더 이상 증가하지 않는 원인이 되기도 한다.

Table 3.

Oscillation amplitude for specific NRMSE values (oscillation frequency: 0.1 Hz, 0.2 Hz, and 0.4 Hz).

V. 결 론

합성개구소나를 장착한 예인체나 자율무인잠수정에서 나타날 수 있는 다섯 가지 경우의 요동 운동에 대해서 영상 생성 오차의 정량적 분석을 수행하였다. 이때 복소수 값을 갖는 기저대역의 영상값의 정규화된 평균 제곱근 오차 NRMSE를 정의하여 정량적 분석의 기준값으로 사용하였다. 요동에 의해서 생성된 영상은 배열의 이동 방향인 축 방향으로 분산되어 나타나며 요동이 클수록 표적 영상의 세기가 감소하였다. NRMSE는 pitch and heave 운동을 제외하고 요동의 크기와 선형적인 관계를 갖는다. 다섯 종류의 운동 중에 yaw and sway 운동이 가장 큰 영향을 미치고, pitch and heave 운동이 가장 작은 영향을 미치고 있으며, 요동의 주파수에 따른 오차의 변화는 크지 않다. 따라서 고해상도의 합성개구소나 영상을 취득하기 위해서는 yaw와 sway를 정밀하게 계측하는 항법센서가 필수적임을 알 수 있으다. 수치해석 결과에 따르면 10 % 오차가 나타나는 최소 각도가 0.03°로서 그 이하의 정밀도를 갖는 항법센서가 요구되고 있으며, 이를 통해 어느 정도 정밀한 항법센서가 필요한지 정량적 기준을 제시하고 있다.